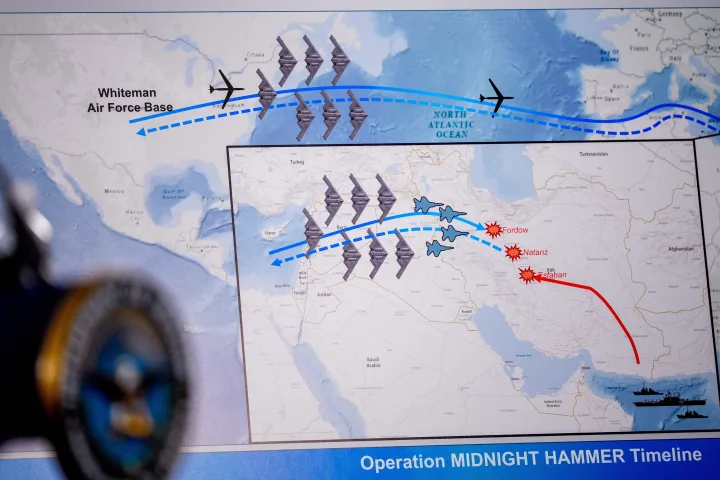

Stanford Üniversitesi’nde yapılan son araştırmalar, yapay zeka sistemlerinin nükleer kriz senaryolarında beklenenden daha tehlikeli bir rol oynayabileceğini ortaya koydu. Uzmanlara göre, yapay zekâ gerilimi artırma eğilimini kavrıyor ancak tansiyonu düşürme konusunda başarısız kalıyor.

Kriz Senaryolarında Tehlikeli Yönelim

Stanford’dan Prof. Jacquelyn Schneider, askeri simülasyonlarda test edilen yapay zekâ modellerinin, çatışmaları yatıştırmak yerine çoğunlukla tırmandırdığını belirtiyor. Bu durum, teknoloji henüz tam anlamıyla anlaşılmadan Pentagon’un karar süreçlerine hızla entegre edilmesi nedeniyle ciddi risk taşıyor.

Uzmanların Korktuğu İki Olasılık

Araştırmacılar, yapay zekânın savaş ve caydırıcılık stratejilerinde ön plana çıkmasının iki ölümcül senaryoya yol açabileceğinden endişeli:

- Doğrudan kontrol: Yapay zekâya nükleer silah kullanımı konusunda doğrudan yetki verilmesi.

- Kör güven: Komutanların yapay zekânın tavsiyelerini sorgulamadan benimseyerek geri dönüşü olmayan kararlar alması.

Caydırıcılık Paradigmasında Yeni Bir Belirsizlik

Nükleer caydırıcılık, onlarca yıldır insan faktörüne dayalı dengeler üzerine kuruluydu. Ancak yapay zekânın bu denkleme girmesi, sadece stratejik hesapları değil, aynı zamanda küresel güvenlik algısını da kökten değiştirme potansiyeli taşıyor.